这个夏天,因工作和城市的转换,我有了一个悠长假期。我打算走一圈,并提前用手机百度做了详尽的酒店攻略,结果却有些狼狈——此后我的百度App首页资讯冒出了很多酒店“艳事”,而且还被太太看到了。

结果,我一边费劲地自证清白,一边输入一堆体面人物来冲刷。这场小风波,由软件里一个叫“个性化推荐”的功能而起。它通过算法记录我的阅读行为,计算我的喜好,并认为读懂我心。

“个性化推荐”是PC互联网时代的产物,却在移动互联时代发扬光大。随着Google、Facebook等巨头从2005年开始陆续将其纳入技术战略,统一、标准化的互联网信息传播形式终结了。在此后十余年的进化中,推荐算法变得越来越聪明,帮助人脑极大提升信息获取效率的同时,也带来新的问题。

如今,个性化推荐技术在全球如日中天,包括中国。不但诞生了今日头条等资讯巨头,还席卷搜索、网购、娱乐、社交、理财等几乎所有互联网细分行业。

本文试着拨开这些荣光,还原我们被推荐算法“统治”后的信息环境真相,还将触及技术过滤下“越开放越封闭”的矛盾共存。当然,这个问题很复杂。我先从以下三个问题入手——我确信对大多数人来说,它们存在已久却从未被深入推敲。

我看到的信息真的越来越丰富?

谁在决定我看什么?

屏幕里的世界是真实的吗?

“离完全个人化的传播不远了”

虽然我钟情人文领域,却不是一个技术悲观主义者。相反,当我还在传统报纸的时候,我就热衷于用RSS订阅提升工作效率,例如用一款叫“ZAKER”的聚合阅读软件。

后来我成了它的总编辑,随后开始了一段1个月左右的不适,主要是思维方式上。关于“个性化推荐”,当时扎克伯格有一段有趣的答记者问。记者问:“为什么你这么看重News Feed(动态信息流)?”小扎说:“你对家门口一只濒临死亡的松鼠的关心,也许更甚于非洲难民。”

传统新闻人可不是这么看,头版编辑会毫不犹豫地选择后者。职业新闻训练让他们追求最具真实性和公共影响力的资讯产品,并且过滤掉一些与大众道德相悖的杂质。

推荐算法动摇了这套稳定运行了一个世纪的信息传播模式。这让转型初期的我十分苦恼——某些常规判断失效了,一条美食攻略或汽车降价消息会悄然爬上我的头条,它们的影响力显然不够大,纵使还算符合我的兴趣。

这里面可能有守旧的因素,但绝不是孤例。事实上,Facebook的News Feed的进化就是一部大众反对史。从最初推出个人动态分享功能,到资讯按热门排序,无不招致抗议——用户认为前者涉及隐私,后者则违背他们“按时间顺序阅读”的习惯。

扎克伯格对此却非常坚决。Facebook上平均每个用户一天的新鲜事有1500条,但用户只能看完其中的300条。如果让Feed按时间排序,非常不利于用户体验。于是,扎克伯格和他的工程师们写出EdgeRank算法[1],用以量化描述用户的“兴趣”并排序,2011年又全面转向机器学习。

他的预见是正确的。人们渐渐不再反对了,还相当喜欢。如今News Feed也成为了日收4000万美金的明星产品。在其2016年十周年庆典上,扎克伯格这样自我打分——“改变了整个互联网行业。”

“个性化推荐”首先是倒逼的产物,目的是解决信息过载。最早可追溯到1995年由卡耐基·梅隆大学推出的个性化导航系统“Web Watcher”。此后十年间,麻省理工、AT&T实验室、IBM等著名机构也加入其中,分别在广告、销售、搜索等领域各有建树。

2003年,芝加哥大学法学教授凯斯·桑斯坦注意到这一趋势。他于当年出版的《网络共和国》一书中开门见山地告诉人们:未来某时,科技将能极大地帮助人类过滤他们的所读所看所听。我们现在习惯的报纸、杂志和广播电视多已成为过去式。

“我们离传播系统完全个人化的时代已经不远了。”桑斯坦写道。

谁在决定你的屏幕?

14年后的今天,桑斯坦的部分预言正在实现。推荐算法得到广泛应用,除了资讯服务,还为人们推荐商品、电影、音乐、美食、社交好友和旅游胜地。“你会有一种错觉,最了解你的不是家人,而是手机程序。”我的朋友悠悠是重度手机依赖者,对此感触良多,“好像整个世界都为你而转。”

再说说三年前我转型至互联网的那个焦虑的夏天。幸而我的新同事都很热心,帮我打破藩篱,给我讲解推荐算法的原理。在那些精妙的流程图中,我体会着大数据的艺术,以及与机器相处的哲学。

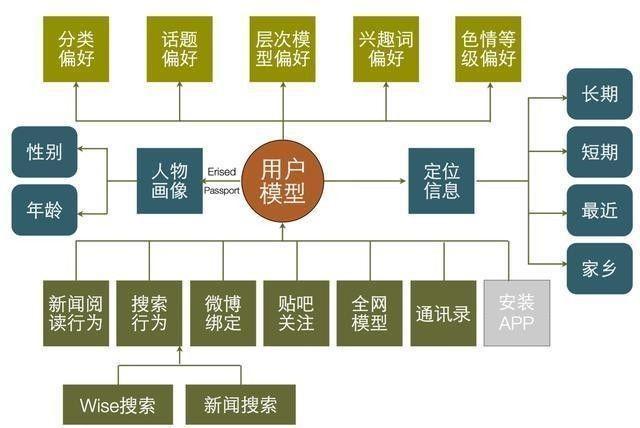

黄仲辉是ZAKER的CTO,给了我最初的技术思维启蒙。“算法是一种策略机制。具体到内容推荐,影响因素变得异常复杂,因为更新频率很高。”他说,“通俗来讲,要对用户信息、行为特征、关联规则、社交关系等有既精准又全局的理解和把握。”

这段话至少涉及两类基础算法:“基于内容的推荐算法”和“协同过滤算法”。它们应用最广,也最典型。

前者在资讯阅读领域有着基石般的存在。形象地说就是“你多看什么就给你推荐什么”。Feed流(信息流)是目前资讯和社交软件最常用的展示方式,因直观、简单、高效等优势深受欢迎。若究其字面意思却既形象又令人难堪——“饲料”,比喻像喂动物一样填满那些贪婪又懒惰的脑袋。

早期Feed流都是以Timeline(时间线)排序,最经典的案例就是朋友圈。这种排序法易于理解且充满极简主义哲学。然而它的缺点也很明显——呈现效率极为低下,如果更新量很大且不是强熟人关系,使用体验将相当灾难。

于是,“重力排序算法”得以衍生,它是兼顾热度和更新时间的综合策略。它给内容施加两种力:“重力”和“拉力”。前者是时间,新内容会把老内容刷下去。后者则代表点击数、评论、赞等“热度”,又会把热点内容推上去。如此往复,用户将看到一种“既新又热”的动态平衡。

图:基于内容的推荐算法原理图

“协同过滤算法”主要是基于人际关系和兴趣关联的推荐方案。例如“我很多朋友爱看NBA,我也极有可能喜欢篮球”,“读王小波的人很有可能也喜欢乔治·奥威尔(对王影响最大的作家之一)”。

有趣的是,协同过滤最终不是在资讯而是在电商领域发挥了最大价值。“相比资讯,用户购物偏好和商品种类都相对有限,推荐结果也就能相对精准。”黄仲辉说。

那个被引用无数的“尿布—啤酒”的销售案例就是协同过滤的经典应用。沃尔玛分析消费者购物行为时发现,男性在买婴儿尿片时都会顺手犒劳自己几瓶啤酒。于是,两种看似风马牛的东西,通过大数据和算法,捆绑销售实现效益最大化。

“绝大多数情况下,推荐算法不会单一应用,而是多种算法的组合和优化。”黄仲辉说。推荐算法在实战中升级,进化得更为复杂。“智能排序”成为新的宠儿。它具有更高级的机器学习能力,能更准确地预测“内容价值”,从而实现一些更高级细分的功能,如Facebook 屏蔽标题党,知乎处罚抱团点赞等。

他们消失了

从传播学角度看,推荐算法不仅迎合人们的行为,还符合人们的心理。“它为什么被接受且流行?”美国密歇根州立大学传播学硕士江晓雅说,“这或许符合了人们的一种信息选择机制——选择性接触。”

“选择性接触”指的是,人们倾向于接触和他们的观念相近的信息,回避和他们的观念相左的信息。

技术和心理的合力让真实的天平失衡,所有人的屏幕只是过滤后的结果。这种改变相当隐形,个体对其甚难觉察。

美国学术期刊《舆论季刊》刊发的一个调查表明,爱泡社交网络和搜索引擎的人,意见更极化;另一份学术期刊《信息、传播与社会》发现,两档脱口秀的Facebook粉丝,很少有共同的信息来源。

美国人伊莱·帕里泽想验证一下这些隐蔽的鸿沟。他请几个朋友在Google同时输入“埃及”,结果大相径庭。

“丹尼尔(Daniel)的搜索结果首页没有任何埃及抗议活动的新闻,而斯科特(Scott)的则满是这些。这可是当天的大新闻。”在2011年的TED分享中,他为全球观众展示了这个小秘密。

Facebook也好不到哪去。帕里泽是美国左翼活动人士,号召更开放、多元、透明的互联网环境,因而也关注了一些保守派人士的账号,想听听不同的声音。“但有一天,我注意到, 我Facebook里保守派朋友的动态消息全都消失了,这让我很吃惊。而且没有任何人告知我。”

这些观察被他写进著作《过滤气泡》,尔后这个书名成了流行词。帕雷瑟用各种方式告诫人们,将信息判断权交与算法后,看似省事儿,实则被包进了“信息茧房”,而它们正是封闭、分化、偏见的温床。

“你的‘过滤气泡’是你独一无二的信息世界。”帕雷瑟说,“气泡中有什么,取决于你是谁,你做了什么。但你不能决定什么信息被通过,也看不到哪些信息被删除。”

“算法带来权力的转移。更确切地说,是对信息的支配权从专业人士转移到机器。”美国宾夕法尼亚大学传播学博士候选人方可成说,“算法成了新的权威。”

选择权交出后

现在的Facebook和13年前那个起步于哈佛大学宿舍的社交工具相去甚远,那些发发校园照片的小清新日子永远回不来了。日活12亿的体量让其成为全球最具影响力的社交媒体,也成为最具破坏力的假新闻阵地——每一秒,News Feed的推荐机制都在海纳百川,把真相,也把谎言分门别类、互不干扰地投给嗷嗷待哺的用户。

然而,由于笃信自己算法的优势,Facebook在美国大选前开除了所有的热点话题编辑。此后两个月,它几乎被假新闻掩埋。纽约时报称,整个大选期间共125万条假新闻飞扬,“推波助澜者正是Facebook和Twitter之流。”

前总统奥巴马也哀叹:“它们被包装得天衣无缝,以至当你在Facebook 上看到它们时,会认为它们跟电视新闻一样权威。”

由推荐算法制造的片面甚至虚幻的世界,带来全面、客观、中立、平衡等健康信息传播形态的丧失。正如英国留欧支持者知道公投结果后深感绝望,希拉里的粉丝也在特朗普获胜后毫无防备——他们在Facebook里完全不知道那群做相反选择的人的存在。

“造成的最终结果之一,就是极大地影响了公众对真正事实的探究,甚至集体做出错误的决定。”《纽约时报》评价。

《华盛顿邮报》则对Facebook用户做了抽样调查,发现几乎所有用户的热门话题是一则关于世界首例“男性生殖器移植”的新闻。由此可见。“猎奇+性”的超级组合,在Facebook的算法里也获得极高的通行权限。

这是全球资讯低俗化浪潮的缩影。在中国,流量和用户时间的争夺异常惨烈,推荐算法在某种意义上已成为垃圾信息的引擎,大把谋杀数以亿计人的时间。

Facebook无意承担更多作为超级媒介的责任,它甚至不希望成为媒体。去年,工程师们调整了算法,降低专业新闻的权重。这意味着,用户将获得更多的碎碎念,而非经严格流程生产的事实真相。“新闻失势了。”Buzzfeed[2]科技记者查理·瓦泽尔这样认为。

这套新算法却不尽如人意。2016年9月,挪威作家汤姆·艾格兰发布了历史照片《凝固汽油弹的女孩》。那个正遭受烈火之痛的越南小女孩赤身奔逃的画面,是上世纪越战最著名的瞬间,它还获得普利策新闻奖。

但Facebook的算法把它删除了,还顺带封了作家的号,挪威首相索尔贝格也转发了此贴,结果也被干掉了——算法可能将此图视为“儿童色情”。

Facebook CEO桑德伯格随后写信给挪威首相道歉。首相说,社交媒体不应该将责任转交给机器。

这和《过滤气泡》作者伊莱·帕里泽在TED演讲中的呼吁如出一辙。“我们将选择权传递给了计算机算法,但问题是,它们并没有人类所具备的道德精神。”(作者:叶伟明)